Токены - галоўная прычына неэфектыўнасці ШІ

Пераклад артыкула TechCrunch ад Kyle Wiggers

Токены - галоўная прычына неэфектыўнасці ШІ

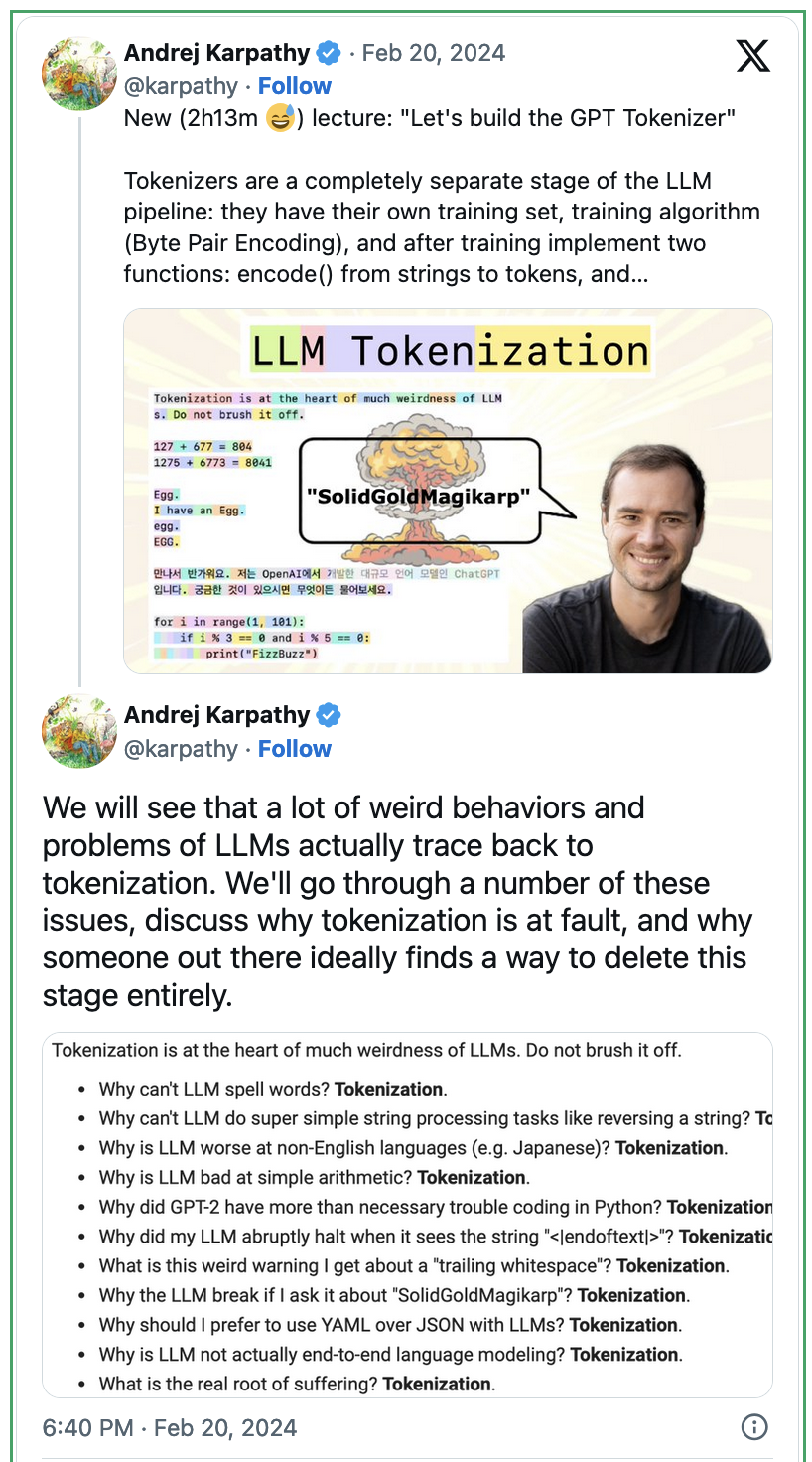

Генератыўныя мадэлі штучнага інтэлекту не апрацоўваюць тэкст так, як гэта робяць людзі. Разуменне іх унутранага "токен"-аснаванага асяроддзя можа дапамагчы растлумачыць некаторыя іх дзіўныя паводзіны і моцныя абмежаванні.

Большасць мадэляў, ад маленькіх тулоў, як Gemma, да вядучай у галіне - GPT-4o ад OpenAI, пабудаваны на архітэктуры, вядомай як трансфарматар. З-за таго, як трансфарматары ўтвараюць асацыяцыі паміж тэкстам і іншымі тыпамі дадзеных, яны не могуць ўводзіць або выводзіць сыры тэкст - прынамсі без вялікай колькасці вылічэнняў.

Такім чынам, з прычын як практычных, так і тэхнічных, сённяшнія мадэлі трансфарматараў працуюць з тэкстам, які разбіты на меншыя, лёгка засваемыя часткі, званыя токенамі, - працэс, вядомы як токенізацыя.

Токены могуць быць словамі, як "fantastic." Або яны могуць быць складамі, як "fan," "tas" і "tic." У залежнасці ад токенізатара - мадэлі, якая ажыццяўляе токенізацыю, яны могуць нават быць асобнымі сімваламі ў словах (напрыклад, "f," "a," "n," "t," "a," "s," "t," "i," "c").

Выкарыстоўваючы гэты метад, трансфарматары могуць прымаць больш інфармацыі (у сэнсавым сэнсе), перш чым яны дасягаюць верхняга ліміту, вядомага як кантэкстнае акно. Але токенізацыя таксама можа ўводзіць пагрэшнасці.

Некаторыя токены маюць дзіўныя прабелы, якія могуць збіць з панталыку трансфарматар. Токенізатар можа закадзіраваць "once upon a time" як "once," "upon," "a," "time," напрыклад, у той час як іншы закадзіруе "once upon a " (які мае наступны прабел) як "once," "upon," "a," " ." У залежнасці ад таго, як мадэль падгатоўлена - з "once upon a" або "once upon a ," - вынікі могуць быць зусім розныя, таму што мадэль не разумее (як чалавек), што значэнне аднолькавае.

Токенізатары таксама па-рознаму ставяцца да рэгістра. "Hello" не абавязкова тое ж самае, што і "HELLO" для мадэлі; "hello" звычайна з'яўляецца адным токенам (у залежнасці ад токенізатара), у той час як "HELLO" можа быць нават трыма ("HE," "LLO"). Вось чаму многія трансфарматары не праходзяць тэст на вялікія літары.

"Складана абмінуць пытанне, што менавіта павінна быць 'словам' для моўнай мадэлі, і нават калі б мы змаглі дамагчыся ідэальнага токеннага слоўніка, мадэлі ўсё роўна працягнулі'разбіваць' існасці на часткі," сказала Шэрыл Фойхт, аспірантка, якая вывучае інтэрпрэтацыю вялікіх моўных мадэляў у Паўночна-Усходнім універсітэце, у інтэрв'ю TechCrunch. "Мае здагадкі, што не існуе такога, як ідэальны токенізатар з-за гэтага роду нявызначанасці."

Гэтая "нявызначанасць" стварае яшчэ больш праблем у мовах, акрамя англійскай.

Многія метады токенізацыі мяркуюць, што прабел у сказе абазначае новае слова. Гэта таму, што яны былі распрацаваны з улікам англійскай мовы. Але не ўсе мовы выкарыстоўваюць прабелы для аддзялення слоў. Кітайская і японская - не выкарыстоўваюць, як і карэйская, тайская або кхмерская.

Даследаванне Оксфардскага ўніверсітэта 2023 года паказала, што з-за адрозненняў у спосабе токенізацыі неангламоўных моў, трансфарматару можа спатрэбіцца ўдвая больш часу на выкананне задачы, сфармуляванай на неанглійскай мове, у параўнанні з той жа задачай, сфармуляванай на англійскай. Тое ж даследаванне - і яшчэ адно - паказала, што карыстальнікі менш "токен-эфектыўных" моў, верагодна, убачаць горшую прадукцыйнасць мадэлі і плацяць больш за выкарыстанне, улічваючы, што многія пастаўшчыкі ШІ бяруць плату за токен.

Токенізатары часта разглядаюць кожны сімвал у лагаграфічных сістэмах пісьма - сістэмах, у якіх друкаваныя сімвалы абазначаюць словы, не звязаныя з вымаўленнем, як кітайская - як асобны токен, што прыводзіць да высокіх лікаў токенаў. Аналагічна, токенізатары, апрацоўваючы аглютынатыўныя мовы - мовы, дзе словы складаюцца з малых значных элементаў, званых марфемамі, як турэцкая - маюць тэндэнцыю ператвараць кожную марфему ў токен, павялічваючы агульную колькасць токенаў. (Эквівалентнае слова для "прывітанне" на тайскай, สวัสดี, складаецца з шасці токенаў.)

У 2023 годзе даследчык Google DeepMind Янні Чжун правяла аналіз, параўноўваючы токенізацыю розных моў і яе наступствы. Выкарыстоўваючы набор дадзеных з паралельнымі тэкстамі, перакладзенымі на 52 мовы, Чжун паказала, што некаторым мовам патрабуецца да 10 разоў больш токенаў, каб перадаць тое ж значэнне на англійскай.

Акрамя моўных няроўнасцей, токенізацыя можа растлумачыць, чаму сучасныя мадэлі дрэнна спраўляюцца з матэматыкай.

Лічбы рэдка токенізуюцца паслядоўна. Таму што яны на самой справе не ведаюць, што такое лічбы, токенізатары могуць разглядаць "380" як адзін токен, але прадстаўляць "381" як пару ("38" і "1") - фактычна разбураючы адносіны паміж лічбамі і вынікамі ў раўнаннях і формулах. У выніку трансфарматары збіваюцца з панталыку; нядаўняя праца паказала, што мадэлі цяжка разумець паўтараючыяся лічбавыя шаблоны і кантэкст, асабліва дадзеныя звязаныя з часам. (Гл.: GPT-4 лічыць, што 7,735 больш за 7,926).

Гэта таксама прычына, чаму мадэлі не вельмі добра рашаюць анаграмы ці пераварачэнне слоў.

Такім чынам, токенізацыя відавочна стварае праблемы для генератыўнага штучнага інтэлекту. Ці могуць яны быць вырашаны?

Магчыма.

Фойхт адзначае "байт-узроўневыя" мадэлі стану, як MambaByte, якія могуць прымаць значна больш дадзеных, чым трансфарматары, без страты прадукцыйнасці, адмовіўшыся ад токенізацыі цалкам. MambaByte, які працуе непасрэдна з сырымі байтамі, якія прадстаўляюць тэкст і іншыя дадзеныя, канкурыруе з некаторымі мадэлямі трансфарматараў у задачах аналізу мовы, лепш апрацоўваючы "шум" як словы са змешчанымі сімваламі, прабеламі і вялікімі літарамі.

Мадэлі, як MambaByte, знаходзяцца на ранніх стадыях даследаванняў.

"Мабыць, лепш дазволіць мадэлям глядзець на сімвалы непасрэдна без накладання токенізацыі, але зараз гэта проста вылічальна немагчыма для трансфарматараў," сказала Фойхт. "Для мадэляў трансфарматараў у прыватнасці, вылічэнні маштабуюцца квадратычна з даўжынёй паслядоўнасці, таму мы сапраўды хочам выкарыстоўваць кароткія тэкставыя прадстаўленні."

Калі не будзе прарыву ў токенізацыі, здаецца, новыя архітэктуры мадэляў стануць ключавымі.

Дадаткова можаце паглядзець наступныя відэа:

https://www.youtube.com/watch?v=zduSFxRajkE

https://www.youtube.com/watch?v=zjkBMFhNj_g&t=4s

ЗЫ: Нагадваю што вы таксама можаце ствараць класныя артыкулы ці пісаць пераклады.

Каментары

(Каб даслаць каментар залагуйцеся ў свой уліковы запіс)